OpenClaw白嫖云部署!附自定义模型API和4种Skills神级用法~

OpenClaw白嫖云部署!附自定义模型API和4种Skills神级用法~大家好,我是袋鼠帝。最近这两周,我的X(推特)和各种群都被刷屏了。作为一名一直在折腾 AI Agent 的博主,我当然坐不住。这几天我抽空疯狂研究OpenClaw,又是买服务器,又是配环境,把OpenClaw的多种玩法撸了一遍。

大家好,我是袋鼠帝。最近这两周,我的X(推特)和各种群都被刷屏了。作为一名一直在折腾 AI Agent 的博主,我当然坐不住。这几天我抽空疯狂研究OpenClaw,又是买服务器,又是配环境,把OpenClaw的多种玩法撸了一遍。

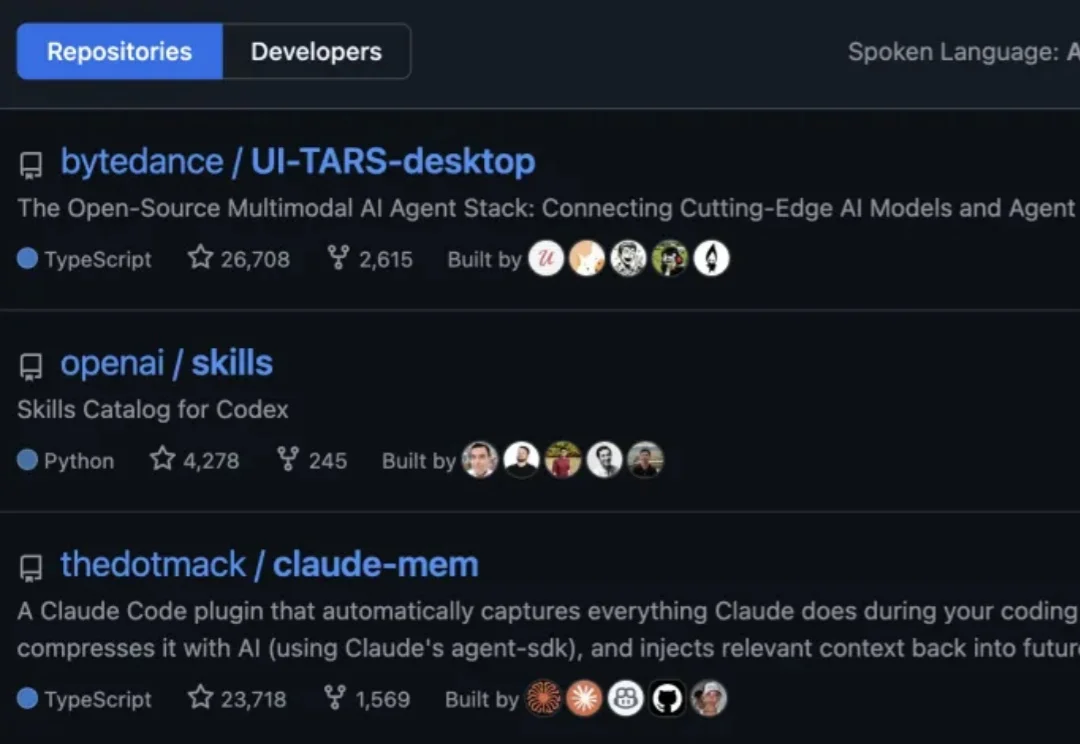

GitHub最新热榜榜首,来自字节。

在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。

27岁独立开发者靠它月入数万,前市场经理睡觉时它写邮件赚钱,柏林辍学生卖自定义技能赚12.7万美元——AI智能体的「iPhone时刻」已来,只是钱还没平均分。

外网都在好奇: 全球模型服务平台 OpenRouter 上这个搜索第一的神秘模型是哪家的? 这个匿名模型叫做「Pony Alpha」。根据 OpenRouter 官方的说法,它是新一代的通用大模型,在编程、逻辑推理和角色扮演方面表现突出,并针对 Agent 工作流进行了优化,具有极高的工具调用准确率。

营销,正式进入 AI 时代。 近日,专注于答案引擎优化(AEO)的 AI Agent 平台 PallasAI 宣布完成数千万人民币融资,由香港上市公司有赞(8083.HK)独家投资。这是该公司三个月内

智东西2月6日报道,据Z Finance独家获悉,近日,答案引擎优化(AEO)AI Agent平台PallasAI完成数千万人民币的天使轮融资,由香港上市公司有赞独家投资。这是PallasAI三个月内获得的第二笔投资。

2026 年 1 月,这一个月所发生的变化,相当于过去 25 年里任意半年的总和。这是一个大事件频发的时期,以至于像 Clawdbot 这样的产品,都能在一周之内三次更名。

过去一年,LLM Agent几乎成为所有 AI 研究团队与工业界的共同方向。OpenAI在持续推进更强的推理与工具使用能力,Google DeepMind将推理显式建模为搜索问题,Anthropic则通过规范与自我批判提升模型可靠性。

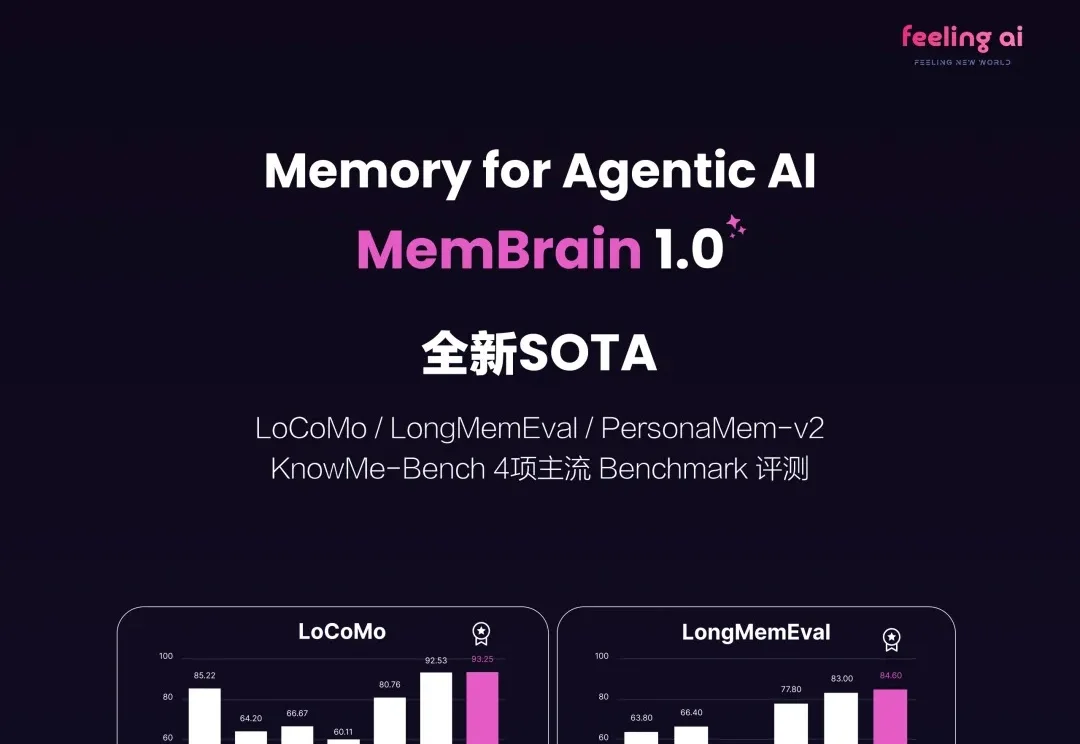

2026 刚来到 2 月,无论是底层模型大厂还是初创公司统统加速开卷,其中 Agentic Memory 方向的快速进化更是把大模型的能力上限推向了 NEXT LEVEL!